【2025年最新】YouTubeオートダビング完全攻略|AI音声吹替で動画を多言語化!

目次

機能概要(自動翻訳・音声吹き替えとは)

YouTubeのオートダビング機能とは、動画の音声を自動で他言語に翻訳し、合成音声で吹き替え音声トラックを生成するものです。動画をアップロードすると、プラットフォーム側でAI技術(音声認識・機械翻訳・テキスト読み上げなど)を使って原稿を翻訳し、別の言語の音声を自動生成します。

この仕組みにより、視聴者は自分の母国語で動画コンテンツを楽しむことができ、言語の壁を越えてグローバルに情報を届けることが容易になります。もともと自動字幕翻訳の機能はありましたが、このオートダビングでは音声での吹き替えが可能になるため、テキストを読む手間なく、より没入感のある視聴体験が得られるのが特徴です。

YouTubeは2024年末から、一部のクリエイターを対象にこのAI吹き替えツールのテストを開始しました(社内プロジェクト「Aloud」によって開発)。まずは教育系や情報系など、知識共有系のコンテンツに重点的に提供されましたが、2025年に入ってからは対象が拡大されつつあり、YouTubeパートナープログラム(YPP)に参加している収益化可能なチャンネルであれば、順次利用できるようになってきています。

この機能はまだ新しい技術であり試験的な段階ですが、今後はより多くのジャンルやクリエイターに開放されていく見込みです。

この記事は、2025年6月24日noteに投稿したものです。

最新情報をgetしたい方はnoteのフォローもよろしくお願いします♪

🔗noteはこちらから見れます。

使い方(設定方法・利用条件など)

利用対象

2024年末時点では、オートダビング機能は一部のYouTubeパートナープログラム(YPP)参加クリエイターに限定提供されており、主に特定ジャンル(教育・情報系など)を中心に展開されていました。しかし2025年2月、YouTube CEOのNeal Mohan氏が「近日中にYPP参加者全員に提供する」と表明し、実際に2025年4月からは、登録者1,000人以上などの条件を満たすYPP参加者すべてに早期アクセスが解放されました。

一方で、収益化していない一般ユーザーには現在も提供されておらず、YPPへの参加が前提となっています。また、この機能の管理は現時点ではPC版YouTube Studioからのみ可能です。

基本的な使い方

オートダビング対応のチャンネルでは、この機能は初期設定で「オン(許可)」になっています。クリエイター側で特別な操作をしなくても、動画アップロード時に以下の流れで自動処理されます。

- 動画をアップロード

従来通り動画ファイルをアップロードするだけでOK。YouTubeが自動で音声言語を判別し、対象言語への吹替え音声をバックグラウンドで生成します。

※追加のソフトや翻訳作業は不要です。 - 吹き替え音声を確認

アップロード後、YouTube Studioの該当動画の「言語」セクションから生成済みの音声トラックをプレビューできます。対応言語の音声はデフォルトで「公開」状態ですが、任意で非公開にしたり削除することも可能です。

また、翻訳精度に不安がある場合は、公開前に内容をチェックして修正することもできます。 - 設定の確認・オン/オフ切り替え

自身のチャンネルでこの機能が有効かどうかは、YouTube Studioの

「設定 > アップロード動画のデフォルト設定 > 詳細設定」から確認可能です。

「オートダビングを許可する」というチェック項目が表示されていれば、そのチャンネルにはすでに機能が適用されています(表示されない場合は、まだロールアウトされていません)。

オフにしたい場合はこのチェックを外して保存すればOK。再度オンにするのも同じ手順で可能です。

なお、動画単位でも「詳細オプション > オートダビングをこの動画で有効/無効」で個別設定が可能です。

(補足)「アップロード動画のデフォルト設定 > 詳細設定」の画面では、チャンネル全体に対してオートダビングをオン/オフ切り替えるチェックボックスが用意されています。

視聴者側の操作

自動吹き替えが適用された動画には、概要欄(説明文)の中に「自動吹き替えである」旨のラベルが表示されます。視聴者は再生画面の歯車マーク(設定メニュー)内にある「音声トラック」項目から、好きな言語の音声を選択できます。

吹き替え版が再生中は、動画プレーヤー上にも「Auto-dubbed(自動吹き替え)」と表示され、オリジナル音声との切り替えも簡単です。また、視聴者の言語設定に応じて、最初から自動的に吹き替え版で再生される場合もあります(例:インターフェース言語が日本語なら日本語音声から再生される)。

ただし、「毎回オリジナル音声で再生したい」といった視聴者向けのグローバル設定は現時点では用意されておらず、言語の切り替えは毎回手動で行う必要があります。この点については、「勝手に吹き替えられて困る」といった声もあり、今後の改善が期待されています。

使用方法→ オートダビングを使用する – YouTube ヘルプ

対応言語一覧(最新対応状況)

現在、対応している言語はまだ限定的ですが、主要な言語はすでにカバーされています。

- フランス語

- ドイツ語

- ヒンディー語

- インドネシア語

- イタリア語

- 日本語

- ポルトガル語

- スペイン語

現在のところ、例えばスペイン語の動画をフランス語に直接吹き替えるといった「英語以外の言語同士の翻訳」は未対応です。この場合、一度英語を介しての変換が必要となります。

YouTubeは今後さらに対応言語を拡充していく方針を公式に発表しており、実験段階の言語(Beta扱い)も早期アクセスという形で随時追加されていく予定です。2024年9月の「Made on YouTube」イベントでも、当初スペイン語・ポルトガル語で始まった自動吹き替え機能が、今後はフランス語やイタリア語など他の言語にも順次拡大されていく計画が示されました。

実際、サードパーティ製の高度なAI吹き替えソリューションではすでに29言語に対応している事例もあり、YouTube側も年内にはさらなる対応言語の拡張が見込まれています。

注意点

上記に記載されていない言語、たとえば中国語、ロシア語、アラビア語などについては、現時点では自動吹き替え機能は非対応です。また、一部の言語は「試験運用版(Beta)」として提供されており、その場合は吹き替え音声が自動で公開されず、人の目で確認してから手動で公開する仕様になるなど、動作に違いが出ることがあります。

どの言語が対応しているかは、YouTubeヘルプに最新の一覧が掲載されているため、グローバル展開を考える際には必ず最新情報を確認するようにしましょう。

精度・品質に関する評価(自動音声合成・翻訳の実力)

結論から言えば、現行のオートダビング機能の精度や自然さは「完璧」とは言えず、利用者からも賛否の声が上がっています。YouTube自身も公式ブログで「この技術はまだ新しく完璧ではない」と認めており、逐次改良中であると言ってます。下記に、具体的な品質面のポイントを解説します。

声質・話者の違和感

現状では、事前に用意された定型的なAI音声(男女各1種類程度)が使われており、元動画の話者に合わせた声色にはなりません。たとえば、元が男性話者でも自動吹き替えでは女性の声があてられるケースが確認されており、視聴者に違和感を与えています。マルチスピーカー(会話形式)の動画でも、登場人物ごとに別声優をあてるようなことはできず、一律同じ声質で吹き替えられるため、「誰が話しているのか分かりにくい」という指摘もあります。

機械的・抑揚のない音声

合成音声ゆえの単調さも課題です。オリジナルの感情や抑揚がほとんど再現されず、淡々とした棒読み調になってしまう傾向があります(参照:bemultilingual.ca)。実際に英語動画を自動吹き替えした例では、元の話者が情熱的かつ高揚した口調で喋っている場面でも、吹き替え版は終始抑揚の乏しいロボット的な音声だったと報告されています。マーケティング的に感情移入を促したいコンテンツでは、この平板な音声では訴求力が下がる恐れがあります。

背景音や音質の問題

現行システムでは、元動画のBGMや効果音などの背景音声をそのまま活かしつつ、音声だけを差し替える処理がなされています(参照:bemultilingual.ca)。しかし、これが仇となり、背景音が歪んだり不自然に聞こえるケースが指摘されています。プロのスタジオであればBGMとナレーションを別々にミキシングできますが、自動吹き替えでは機械的に音声部分のみを置換するため、元音声との食い違いでノイズが発生するようです。

翻訳精度・用語の問題

自動翻訳である以上、訳語の誤りや不適切な翻訳も起こりえます。特に専門用語・固有名詞・慣用句などで直訳調になったり、意味が変わってしまう可能性があります(参照:support.google.com)。また、元の発音が不明瞭だった場合に認識エラーが起き、そのまま誤訳につながるケースも考えられます。こうした誤訳は、マーケティングメッセージの齟齬やブランド名の誤読につながるリスクがあるため、注意が必要です。

視聴者からの声

すでにテスト段階でこの機能に触れたユーザーからは、「勝手に吹き替わって非常に邪魔・迷惑だ」「とにかくオリジナル音声に戻す方法を教えてくれ」といった厳しい声も出ています(参照:bemultilingual.ca)。Reddit上の関連スレッドでも、「YouTubeが動画を自動で吹き替えるようになったが本当に迷惑だ」という苦情が話題になりました(参照:air.io)。一方で、英語がわからない視聴者からは「自分の言語で理解できて嬉しい」とのポジティブな意見もあると推測されますが、現状ではSNS上で不満の声が目立つ状況です。また、クリエイター側からも「品質が低いので自分の動画には使いたくない」という反応が少なくありません(参照:air.io)。

今後のアップデートと展望

以上のように課題は多いものの、YouTube側も改良に積極的です。今後のアップデート予定としては、AI研究機関のDeepMindチームと協力し、「Expressive Speech」技術で話者のトーンや感情、周囲の雰囲気を吹き替え音声に反映させる高度な合成音声を導入する計画があります(参照:blog.youtube、pc.watch.impress.co.jp)。これは2024年9月にプレビュー発表されており、近い将来に実装されれば、現在指摘されている「感情表現の乏しさ」はかなり改善される見込みです。また、2025年内には対応言語の拡大や、より自然な音声へのアップデートも継続して行われると公式にアナウンスされています。

総評

現段階では「実用的だが、品質面では発展途上」という評価です。ただし、技術の進歩により、今後は人間のナレーションに近づくことが期待されるため、クリエイターやマーケターにとっては注目すべき分野であることは間違いありません。

実際の活用事例(マーケティング・グローバル展開における事例)

マーケティング分野やグローバル展開において、オートダビング機能は大きな可能性を秘めています。トップYouTuberのMrBeast氏などは以前から動画を複数言語に吹き替えて別チャンネルで配信し、世界規模の視聴者獲得に成功してきましたが(彼はプロの声優を起用した「人力」吹き替えで成果を上げました)、YouTube側も彼の成功に触発され「多言語吹き替えが次のプラットフォーム成長の鍵」と認識しています。オートダビング機能は、そうした試みを一般のクリエイターや企業にも手軽に実現させる民主化ツールと言えます。

いくつか具体的な活用イメージや事例を紹介します。

教育系・HowToコンテンツのグローバル展開

料理レシピやDIYチュートリアルなど「知識共有」タイプの動画は、言語の壁を越えて需要があります。例えばフランス人シェフの料理動画を自動吹き替えで英語や日本語に音声翻訳すれば、現地語がわからない視聴者にもアプローチ可能です【blog.youtube】。実際、YouTubeによれば、フランスのクリエイターの一例では視聴時間の95%以上が国外からというケースもあり【blog.youtube】、言語さえ克服すれば世界中から視聴者を呼び込める潜在力が示されています。

企業のプロモーション動画の多言語対応

グローバル企業のマーケティング部門にとって、製品紹介やカンファレンス動画を各国語にローカライズするのは大きな負担でした。オートダビングを使えば、たとえば英語で制作した新製品紹介動画を自動でスペイン語やヒンディー語など主要市場向けに吹き替えて公開することができます。これにより現地語版の追加動画を別途制作することなく、一つの動画で多地域にリーチできるようになります(字幕よりもしっかり情報が伝わりやすいメリットがあります)。

あるAI字幕サービス企業の発表によれば、ニュース配信でライブ音声をAI翻訳・吹き替えしてスペイン語圏に同時届ける試みも始まっており、視聴者層拡大と収益増に繋がったといいます。マーケティングにおいても「言語ごとに別動画を作らずとも一元化できる」効率性は大きな武器です。

クリエイターの新規市場開拓

中規模のYouTuberでも、この機能を使って視聴層の国際化に挑戦する例が出始めています。例えばある英語圏のガジェット解説チャンネルが吹き替えを有効にしたところ、スペイン語やポルトガル語の視聴が増え、新たなファン層が獲得できたといったケースが報告されています(※具体的データは非公開ながら、投稿者談)。またYouTube公式によれば、複数音声トラックを提供した動画では、総視聴時間の40%以上が吹き替え版視聴によるものになっているとの統計もあり、多言語対応が再生回数・視聴維持率向上に寄与していることが窺えます。

このように新興市場へのテストとして吹き替え機能を使い、反応が良ければ本格的なローカライズ戦略を練るという段階的アプローチも可能です。実際、専門家は「自動吹き替えはノーコスト・低労力で各言語市場の潜在視聴者の反応を調べる絶好の手段」だと指摘しています。

以上のように、オートダビング機能はグローバルマーケティングのハードルを下げる実践的なツールとして活用され始めています。ただし、現在の品質上の制約も踏まえ、重要なコンテンツでは自動吹き替え版をそのまま使うのではなく、人間の目によるレビューや必要に応じた修正を加えることが推奨されます。

例えば自動吹き替えで反響を掴んだ後、視聴数が多い言語についてはプロの声優を起用した吹き替え版や字幕版を改めて用意し、ブランドイメージを高める、といったハイブリッドな活用も考えられます。

マーケターにとって重要なのは、この機能を出発点(スタート地点)としてデータを収集し、そこから本格展開の意思決定を行うことです。最初から完璧を求めすぎず、「とりあえず走らせてみて市場の声を聞く」という姿勢で試行するのが、現時点では有効な戦略と言えるでしょう。

オートダビング機能の活用メリット・デメリット

メリット

世界規模のリーチ拡大

言語の壁を取り払い、新たな国・地域のオーディエンスを獲得できます。吹替え音声を提供した動画では、全視聴時間の40%以上が他言語音声で視聴されるというデータもあり、コンテンツの国際的な露出が飛躍的に向上します。

視聴者エンゲージメント向上

視聴者が母国語で視聴できるため、理解度や満足度が上がり、結果として視聴維持率の向上やチャンネル登録の増加につながる可能性があります。字幕よりも負担が少ないため、最後まで視聴してもらいやすくなります。

コンテンツローカライズのコスト削減

従来はプロの翻訳者や声優を雇う必要があり、多言語対応には莫大なコストと時間がかかっていました。しかし、オートダビングなら追加コストゼロ・ほぼワンクリックで複数言語版を用意できるため、予算の限られたマーケティングチームや個人クリエイターでも手軽に多言語展開が可能になります。

市場テストに最適

新規市場への投入前にコンテンツの受容度をテストするためのマーケティングツールとして有効です。各言語圏での再生動向を簡単に確認でき、好反応が得られた言語に絞って本格的に投資するなど、データドリブンな判断が可能になります。

社内研修・教育用途の効率化

マーケティング用途に限らず、グローバル企業における研修動画や製品トレーニング資料にも活用できます。多言語対応によって各国従業員に迅速に情報展開でき、企業のナレッジ共有にも大きく貢献します。

デメリット(留意点)

翻訳ミスによる誤解リスク

自動翻訳の誤りにより、意図と異なるメッセージとして伝わる恐れがあります。たとえば商品説明のニュアンス違いや、不適切な訳語がブランドイメージを損ねるなど、機械翻訳ならではのリスクがあり、重要なメッセージには専門家による確認が必須です。

音声品質・表現力の限界

現行の合成音声は単調で、感情表現に乏しく、人間のナレーションほどの説得力や臨場感がありません。また、話者の性別や声質が変わる違和感もあり、視聴体験を損なう可能性があります。感性に訴えるプロモーション用途では特に注意が必要です。

視覚と音声の不一致

吹替え音声は当然ながら話者の口の動きと一致しないため、いわゆる「口パクずれ」が生じます。これを不快に感じる視聴者も一定数おり、字幕を好む層からは敬遠されることがあります。

複数話者コンテンツとの相性

対談や座談会形式の動画では、全員が同じ声で吹き替えられるため、誰が話しているか判別しづらくなることがあります。さらに、早口の掛け合いなどではAIの処理が追いつかず、不自然な間が生じるケースもあり、コンテンツの種類によっては適していません。

ユーザー体験の制御困難

視聴者が設定を変更しない限り、自動で吹替版が再生される仕様になっており、オリジナル音声で視聴したいユーザーからは「勝手に吹き替えになるのが不快」との声も上がっています。ユーザー体験を損ねないための周知やガイダンスが必要です。

対応言語の限定

現在対応しているのは主要な8言語+英語のみです。それ以外の市場(例:中東や東南アジアの一部言語)には対応していないため、該当市場では別途対応が必要です。ただし、今後は対応言語が増えていくことが期待されています。

まとめ:賢く使えば強力な武器になる

以上を踏まえると、YouTubeのオートダビング機能は「万能ではないが、強力な補助ツール」として活用するのが適切です。

マーケターにとっては、低コストでグローバル展開の可能性を探れる魅力的な手段でありながらも、品質面の課題には注意が必要です。

最も効果的な使い方としては、自動吹替え+人手によるチェックのハイブリッド運用や、市場テスト目的での限定活用が挙げられます。

適切に活用すれば、オートダビング機能は新たなオーディエンスとの接点を生み出し、あなたのコンテンツ戦略の幅を大きく広げてくれるでしょう。

Youtube以外の自動音声吹替界隈に関して↓

主要企業と最新動向

Google / YouTube(Aloud)

Googleは自動音声吹替の先駆的プロジェクト「Aloud」を開発しました。2022年にArea 120発の実験として公開され、英語動画をスペイン語・ポルトガル語などに自動翻訳・吹替できるツールです。Aloudは動画の音声を文字起こしし、クリエイターが編集できる字幕テキストを提供した後、それを翻訳して別言語のナレーションを合成します。YouTubeは2023年にこのAloudチームを正式に招聘し、数百人のクリエイターとテストを開始しました。対応言語は英語・スペイン語・ポルトガル語など数言語ですが順次拡大中です。将来的には元の投稿者の声質に似せた合成音声、話者の表情豊かな抑揚、映像のリップシンク(口の動きと吹替音声の同期)にも対応する計画で、これらは開発中。

YouTubeは2023年末に動画へ複数音声トラックを追加できる機能を導入し、クリエイターが一つの動画で多言語音声を提供できるようにしました。言語の壁をなくすことで視聴者を増やし、「言語に閉じ込められた知識」を解放する狙いがあります。実験では、動画を別言語に吹き替えるだけで視聴回数が二桁%以上増加するケースも報告されています。

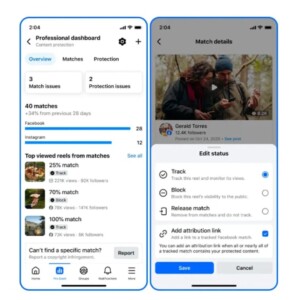

Meta(Facebook / Instagram)

Metaは2023年に音声AIモデルVoiceboxと大規模多言語音声モデルMassively Multilingual Speechを発表しました。2024年9月の「Meta Connect 2024」では、InstagramとFacebookの短尺動画(Reels)の音声を自動翻訳・吹替するAI翻訳ツールを公開。このツールは投稿者本人の声色をシミュレートし、映像の口の動きと同期させるもので、まずは英語とスペイン語の相互変換でテストが行われています。ザッカーバーグCEOは「本人が別言語を話しているように見える技術」と位置付け、SeamlessM4Tという100言語対応の統合音声翻訳モデルをオープンソース化。プライバシーや安全面に配慮しつつ、限定テストで人間のレビューやユーザフィードバックを取り入れながら品質向上を図っています。

Microsoft

2012年にリアルタイム音声翻訳デモを成功させて以来、Skype TranslatorやMicrosoft Translatorで実績を積んできました。2023年には数秒の音声から声質を学習するVALL-Eを発表。2025年6月にはオープンソースの音声翻訳モデルPhi-Omni-STを公開し、音声入力から直接他言語音声を生成するマルチモーダル大規模モデルをリリースしました。Azure Cognitive Servicesを通じて音声認識、翻訳、音声合成のAPIを提供し、TeamsやSkypeでも通話字幕翻訳を実装しています。

Amazon

AWSのTranslate、Transcribe、Pollyを組み合わせれば動画の自動吹替を実装できます。2025年3月にはPrime Videoの一部作品にAIアシスト吹替を試験導入し、まずは英語版や南米スペイン語版のない12タイトルでテストを開始。人間の翻訳者とAIを組み合わせるハイブリッドで品質管理を行っています。Alexaには同時通訳モードが実装され、Echoデバイス間で異なる言語の会話をリアルタイムに通訳できます。

OpenAI / Spotify

OpenAIのWhisperは多くの自動吹替システムで文字起こしに利用されています。2023年9月にはSpotifyと協業し、人気ポッドキャストをスペイン語やフランス語に翻訳したうえで本人の声色を再現した合成音声で配信。数秒のサンプルから声を複製する技術を用い、安全とプライバシーに配慮しながら限定提供を開始しています。ChatGPTにも音声読み上げ機能を追加し、LLMの文脈理解を活かした翻訳精度向上が期待されています。

ElevenLabs

2022年創業のElevenLabsは音声合成とクローン音声技術で急成長し、評価額11億ドル超のユニコーン企業に。2023年10月にAI Dubbingをリリースし、元の話者の声質を保ったまま最大20言語に翻訳が可能です。ノイズ除去、話者分離、リップシンクを自動処理し、Eleven Multilingual v2モデルが基盤となっています。2023年に8000万ドルを調達し、Voice LibraryやVoiceLabを追加。悪用防止策として無料ユーザのクローン作成を制限し、有料ユーザにも厳格な利用規約を適用しています。

Respeecher

ウクライナ発のRespeecherは音声クローン変換に特化。ディズニーの『マンダロリアン』『ボバ・フェット』で若き日のマーク・ハミルの声を再現しました。故人俳優の声を蘇らせるプロジェクトや、多言語展開でオリジナル声優の声質を保った吹替にも活用され、ラジオや映画で俳優本人そっくりの声を用いる新しい演出が進んでいます。

その他のスタートアップ

PapercupはBloombergやSky Newsの動画をスペイン語に吹替えて配信し、ラテンアメリカ向け視聴者を拡大。イスラエルのDeepdubは映像作品向けAI吹替で注目され、英国のFlawless AIは映像上で口の動きを別言語音声に合わせて変化させる技術を開発しています。HeyGenやWavelはElevenLabsの音声合成を組み込み、字幕編集や音声差し替えを手軽に行えるWebツールを提供。放送業界向けのプロ品質ハイブリッド翻訳から中小企業向けのDIYツールまでサービス形態が多様化し、2023年はAI音声吹替の初期リーダー企業が台頭した年と位置付けられます。

技術的課題点(現状の限界と論点)

AIによる自動音声吹替は急速に進歩していますが、まだいくつかの技術的ハードルが残っています。主要な論点ごとの限界を整理します。

音声の自然さ・感情表現

少し前までのAI合成音声は抑揚や感情に乏しく、機械的で平坦だと指摘されていました。カーナビやスマートスピーカー向けの音声は滑らかでも単調で、喜怒哀楽や「間」の表現が再現しづらかったため、ドラマや映画の吹替には不向きでした。しかし 2023年ごろから音声クローン技術が進歩し、単一モデルで幅広い感情や話法をカバーできるようになっています。ElevenLabsはセリフごとに喜怒哀楽のトーンを指示できる機能を提供し、OpenAIやMicrosoftも数秒の肉声サンプルから声質と話し方を学習し、感情を込めた合成を実現しました。それでも皮肉交じりの口調や極端に早口の興奮状態など、人間特有の微妙な抑揚を完全にエミュレートするにはさらなる研究が必要です。

複数話者・会話への対応

一つの動画内に複数の登場人物がいる場合、それぞれを認識し区別して吹替える必要があります。現在のシステムはまず話者分離を行い、個別に翻訳・合成しますが、話者がかぶせ気味に話す場面や騒音下では分離精度が低下し、誤った人物の声で吹替えるリスクがあります。実在人物の場合は声をクローンするか、性別や年齢に応じた合成音声を選ぶ判断も必要です。細かな話者交替のタイミングや早口での掛け合いは特に難しく、笑い声や相槌が混ざると処理が追いつかないことがあります。

翻訳精度と文脈・ニュアンス

映像コンテンツではセリフのニュアンスやジョークの誤訳が視聴体験を損ねる恐れがあります。文化依存の慣用句や俗語を直訳してしまう問題も依然として残っています。Synthesiaは用語集で専門用語や固有名詞の訳を固定できる機能を準備中で、Amazonは翻訳文の長さを自動調整して元の発話時間に合わせる技術を開発しています。直訳の正確さだけでなく、場面に即した意訳を生成する力が求められるため、大規模言語モデルと専門翻訳者によるハイブリッド運用が現実的です。

リップシンク(口の動きの同期)

吹替音声が映像の口パクと合わないと不自然さが目立ちます。自動吹替ではまず翻訳音声の長さを原音声とそろえ、次に音素タイミングを調整して発音を合わせる方法と、映像側をAIで合成し直す方法の二つが採られています。後者の代表例が Flawless AI の TrueSync で、別言語音声に合わせて口の動きを再生成しますが、完全自動では微妙なズレが残り手作業の修正が必要でした。Synthesiaは 2024 年初頭に 4K 映像対応の自動リップシンクを実現したと発表しています。アニメやゲームのように口パクが単純なコンテンツでは実用レベルに達していますが、実写の細かな表情変化に完全一致させることは依然として難題です。

話者の権利・倫理

他人の声を無断で利用できてしまうため、著名人の声真似や故人の声の再現には倫理的・法的問題が伴います。2023 年には存命俳優に無許可で AI 合成音声を充てようとした事例が報じられ、俳優組合も無断声クローン使用を禁止事項に加え始めました。ElevenLabsはクローン音声へのアクセス制限や不正利用検知を実装し、YouTube の Aloud では AI 合成音声であることを明示する仕組みを導入しています。今後は音声ウォーターマークや識別子の埋め込みなど、技術的・制度的対策が進む見込みです。

応用可能性:今後の展開予測と分野別インパクト

自動音声吹替技術は今後、多様な分野で活用が加速すると見られます。2025年時点の動向を踏まえ、主要分野ごとの具体例と将来展望を示します。

AI業界(マルチモーダルAIとの統合)

音声吹替は大規模言語モデルやマルチモーダルAIと統合され、さらに賢く柔軟なシステムへ発展すると予測されます。音声認識、翻訳、音声生成を単一モデルで完結させる流れが進み、文脈理解力を生かした意図翻訳やトーン調整も自動化されるでしょう。MicrosoftのPhi-Omni-STのように、ASR・MT・TTSを分離せず直接音声同士を翻訳するモデルが先駆けです。クラウド提供により、開発者は高品質な音声翻訳を簡単に組み込めます。オンライン会議や音声対話エージェント、動画ローカライズ・スイートなど、音声吹替とマルチモーダル技術のシームレスな融合が進む見込みです。

マーケティング(グローバル動画戦略とローカライズ効率化)

企業の広告やプロモーション動画は、AI吹替で多言語展開が容易になります。オリジナル動画を一度制作すれば、自動で中国語・スペイン語・日本語などに吹替えて同時公開でき、母語でリーチ可能な顧客が大幅に増加します。Bloombergがスペイン語吹替で新規視聴者を獲得した例や、大手広告代理店の試験導入が示すように、コスト削減とスピード面で優位です。インフルエンサーマーケティングでも、多言語吹替により英語圏のクリエイターが他言語圏でもファンを獲得できます。将来は、映像中の看板やテロップも自動翻訳して差し替える技術が実用化され、視覚情報を含めた完全ローカライズがボタン一つで可能になると見られます。

教育(eラーニングとバリアフリー教育)

教育分野はAI吹替への恩恵が最も大きい領域の一つです。大学講義や専門講座を多言語音声で提供すれば、学びたい人が母語で理解できます。CourseraやUdemyでは多言語吹替付き講座の試験提供が始まり、海外大学講義の日本語吹替プロジェクトも進行中です。視覚障がい者や難読症の学習者にとって、字幕より音声が有効なケースもあり、バリアフリー教育の観点からも重要です。少数言語への対応が進めば、母語教育支援にも寄与します。安価かつ大量の教材ローカライズが可能となり、世界規模で教育の質とアクセシビリティを高めるポテンシャルがあります。

まとめ

自動音声吹替技術は黎明期を脱し、普及フェーズに入りました。テック企業とスタートアップの競争・協業により技術成熟は加速し、メディアの垣根を越えた統合翻訳が進むと期待されます。一方で、声というアイデンティティを扱う技術ゆえ、倫理や法規制の整備も不可欠です。クリエイターと視聴者の信頼を確保しながら、安全で創造的な活用法を模索していくことが、今後の鍵になるでしょう。

執筆:赤髪 / SNS戦略家

AI × 心理 × SNSアルゴリズムで、ビジネスの未来を読み解く。

LINE公式アカウントでSNS戦略や最新トレンドを随時お届けしています。

より深い情報や具体的な活用ノウハウに興味のある方は、下記リンクからぜひご登録ください。

https://lin.ee/60b4Awk